生成AIの主要なリスクとAIガバナンス

ChatGPTやGemini、Claudeに代表される生成AIは、人間を凌駕する高い処理能力から急速に普及が進み、近年はテキスト・画像・音声・映像などの生成にとどまらず、推論能力についても急速に精度を高めています。しかし、振る舞いの不確定性に起因し、モデル開発を行わずAIをサービスとして提供する企業や、サービスを利用する企業であっても、生成AIのリスクを検知し、サービス提供や利用の目的・範囲に鑑みながらリスク許容度を評価し、適切に対処するAIガバナンスの整備・運用が求められています。総務省・経済産業省が2024年4月に取りまとめたAI事業者ガイドラインでも、「AI開発者」「AI提供者」「AI利用者」の全てに対してリスクへの対処が推奨されています。

以下に生成AIの主要なリスクを紹介します。これらのリスクはOWASP Top10 for LLM Applications(※1)のように、コミュニティによって継続的に分類・改訂が行われています。(OWASP=Webアプリケーション、ソフトウェアセキュリティの向上を目的とした世界最大の非営利団体)

- バイアス

学習データの偏りに起因して、AIモデルが特定の不変的な個人属性(人種・性別・国籍など)に対する差別的表現をするリスク。AI提供者には、提供範囲に応じて、レッドチーミング(攻撃者がどのようにAIシステムを攻撃するかの観点で、AIセーフティへの対応体制および対策の有効性を確認する評価手法)による事前評価、またはガードレール機能を用いた出力のバイアスの検出と出力制御といった対策が求められます。 - ハルシネーション

AIモデルが事実と異なる情報を出力するリスク。AI利用者側でのファクトチェックの徹底、クリティカルな用途での人的介入に加え、事実との整合性が求められる用途の場合は、AI提供者によるRAG等による知識補完が求められます。 - 悪用・目的外利用

プロンプトインジェクション等の悪意のある生成指示により、AIモデルが本来の動作から逸脱した出力をするリスク。AI提供者には、提供範囲に応じて、ガードレール機能を用いたモデル入力に対するインジェクションや目的外リクエストの検出と制御、さらには、AI利用者に対する禁止行為の明確化、注意喚起が求められます。 - プライバシー侵害

学習データに含まれる個人情報を出力してしまう、または、入力プロンプトに含まれる個人情報を学習し、第三者に出力してしまうリスク。AI利用者は、自身の個人情報の安易な入力を回避することに加え、入力情報を再学習しないサービスを選定することが求められます。 - 機密漏洩

入力プロンプトに含まれる機密情報を学習し、第三者に出力してしまうリスク。AI利用者・AI提供者の双方について、扱う情報の機密性が高い場合、組織固有の独立した論理区画で動作する、入力情報の再学習のないサービスを選定することが求められます。 - 財産権の侵害

AIモデルが学習データに含まれる第三者の知的財産や肖像を再現することで、権利の侵害を生じるリスク。AI提供者は、モデルの著作権侵害耐性を調査・評価し、利用者に対する禁止行為の明確化、注意喚起を行うことが求められます。AI利用者は、出力の利用前の検索エンジン等による類似性確認や、人的確認を行うことが求められます。

以上のリスクは生成AIの「生成能力の高さ」が及ぼす負の影響と言えるでしょう。ここからは、Agentic AIの「タスク処理能力」が及ぼす負の影響について解説します。

Agentic AIの特性

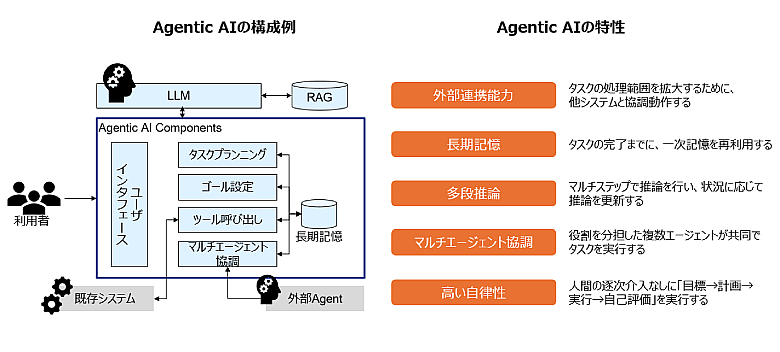

エンタープライズに適したAI活用形態として注目されるAgentic AIは、タスクの目標と処理フローの立案から、アクセス可能な外部APIや他システムとの連携まで、自律的に実行するAIエージェントの一種です。NTT DATAが生成AIの活用コンセプトとして掲げる Smart AI Agent® においても、LLMの高度な処理能力を用いて、ワークフローの生成や他のAIエージェントとの協調、出力の改善を自律的に行うことを目標に、技術開発を進めています

Agentic AIは、従来型のAIや生成AIに比べ、行動の自由度・継続性・外部環境との双方向性、実世界に対して直接影響を与える性質が特徴です。そのため、従来型のAIや生成AIのリスクに加えて、新たなリスクの管理が必要となります。

図:Agentic AIの構成例と特性

Agentic AI固有のリスクとその対応

では、このようなAgentic AIの特性をふまえ、その特性に起因するリスクにどのような対策をとればよいのでしょうか。それぞれの「特性」ごとに想定される「リスク」と対策を以下に紹介します。なお、Agentic AIの応用範囲の拡大に伴って新たなリスクが検知される可能性もあるため、以下がリスクの全てを網羅しているとは限らない点に注意してください。

- 「外部連携能力」と「権限昇格」リスク

Agentic AIは自己の外部にあるツールやAPIを呼び出す(データを入出力する)ことで、タスクの文脈に適したプロンプトの生成や出力の外部反映を実施します。このとき、外部ツールやAPIに渡すコマンドが本来の権限を逸脱することで、対向システムのデータベースを破壊するなど、悪影響を及ぼすリスクがあります。

これを抑止するためには、Agentの通信先、通信先でアクセスするデータ範囲、利用可能なコマンド(API)を漏れなく洗い出し、Agentに与えられた権限が適切であるかを評価すること、Agentの発したコマンド履歴を記録しておくこと、ならびに、コマンドを受領する側ではなりすましへの対策が求められます。 - 「長期記憶」と「記憶の汚染」リスク

Agentic AIはタスク完了までに、ユーザーや外部システムと複数回の対話・インタラクションを行う場合があり、この間に得られた情報や生成した結果を記憶し、タスク完了まで再利用します。このAgentの記憶に、悪意のある振る舞いの指示が含まれた場合、意図しない挙動を生じるリスクがあります。

これを抑止するためには、記録対象を再利用する前に、プロンプトインジェクションを検出し、適切に制御することが求められます。 - 「多段推論」と「可観測性の不足」リスク

Agentic AIは、与えられたタスクをマルチステップ(多段)で実行する特性があるため、推論の経緯が不透明(ブラックボックス)化し、望まない挙動に対して対処不能となるリスクがあります。

これを抑止するためには、推論の各段階でのAI処理の推論経緯をトランザクションIDと併せて記録し、原因解析を可能にしておくことが求められます。 - 「マルチエージェント協調」と「曖昧な責任分界」「創発的共謀」リスク

複数のエージェントが協調動作する間に、評価関数の最適化の過程で、例えば売価決定エージェントであれば極端な価格の釣り上げなど、破壊的な混乱を生じ、かつその責任の所在が曖昧になるリスクがあります。

これを抑止するためには、各エージェントが監査可能なログを記録することと併せて、与えたタスクを処理する過程で、生じてはいけない状態(例えば価格変更エージェントであれば価格上限の超過など)を基準に、人的承認の介入条件を定義しておくことが求められます。 - 「高い自律性」と「不適切な意思決定」「過度な依存」リスク

自律的にタスクを処理可能な能力に依存し、大規模な影響を生じる意思決定など、Agentic AIに過度な依存を生じてしまう、または、その利便性の高さ故に、本来成長させるべき人的能力の成長機会を失うリスクがあります。

これを抑止するためには、活用を企画する段階で、タスクオーナーが責任を果たすべき範囲に対し、エラー時の影響範囲とAgent処理範囲の妥当性を評価した上で、適切に自動化範囲を調整することが必要です。加えて、リアルタイムでの監視によって、必要に応じて人的確認・承認の介入を必須化する、あるいは処理の状況に応じて強制遮断を可能にしておくといった対応も有効です。

また、組織成長の視点から、自動化範囲が中長期的な人的成長機会の損失に相当するかを評価し、範囲を調整することも求められます。

Agentic AIを活用する企業は、生成AIのみならず、Agentic AI特有のリスクへの対処についても、リスクベースアプローチ(※2)の考え方を踏襲し、リスクの優先順位や影響度に応じて対応することが求められます。また、協調先のシステムやエージェントに対しても必要な措置が可能となるよう、ガバナンスを有効化しなければならない点にも留意が必要です。

潜在的なリスク(危険性)を特定、分析、評価し、リスクの大きさに応じて優先順位をつけ対策を講じる手法。

最後に

Agentic AIは、驚異的な生産性向上が期待される一方で、その行動の自由度・継続性・外部環境との双方向性、実世界へ直接影響を及ぼすことなどの特性に起因したリスクへの対策を図ることが求められます。また、Agentic AIのリスクは「社会が受容可能な自動処理の境界とは」という本質的な問いを含んでおり、高度化の進む Robotics 技術のリスクの議論にも通底します。AI提供者やAI利用者は、この問いに対し不断の観測と対策の高度化の継続が求められていると言えるでしょう。

NTT DATAでは、AIモデルの安全性を、敵対的攻撃手法を用いて評価する、レッドチーミングによる生成AIモデル安全性評価サービスを提供しています。レッドチームはもともとサイバーセキュリティの分野で発展したアプローチで、攻撃者の視点でシステムやネットワークに模擬攻撃を行い、弱点をあぶりだす評価手法です。この考え方を生成AIに応用し、生成AIに対してあえて「意地悪な入力」を与えたりルールの隙間を突く問いを試したりすることで、モデルやシステムがはらむリスクを発見し、評価します。今後、最新のAgentic AIのリスクもカバレッジに含めることで、お客さまのAI活用と安全の両立に寄与していきます。

参考:

生成AI(Generative AI)についてはこちら:

https://www.nttdata.com/jp/ja/services/generative-ai

AIエージェント(AI Agent)についてはこちら:

https://www.nttdata.com/jp/ja/services/generative-ai/ai-agent

AIガバナンスについてはこちら:

https://www.nttdata.com/jp/ja/services/data-and-intelligence/governance/

あわせて読みたい:

スペシャリストが語るビジネス改革に効く最新動向

連載第1回「AIエージェントが変えるビジネスの未来」はこちら:

https://www.nttdata.com/jp/ja/trends/data-insight/2025/0910/