Agentic AIとは

AI技術の進化はそのスピードが速く、さまざまなサービスが開発・提供されていますが、昨今注目されているのが「Agentic AI」です。これは、LLM(大規模言語モデル)を活用し、タスクの分解・計画・実行・評価を自律的に行うAIの形態を指します。

従来のAIが人間の指示に従って動作するのに対し、Agentic AIは目標達成のために自ら判断し、行動を起こす能力を持ちます。たとえば、業務の自動化において、複数のタスクを自律的に組み立て、外部システムと連携しながら実行することが可能です。このような特性は、業務効率化や専門性の高い業務支援において大きな可能性を秘めています。

一方で、その高い自律性ゆえに、従来のAIとは異なるリスクや倫理的課題が浮上しています。そこでNTT DATAでは、Agentic AIのさらなる社会実装に向けて、社外有識者との対話を通じて、考慮すべき観点を探りました。

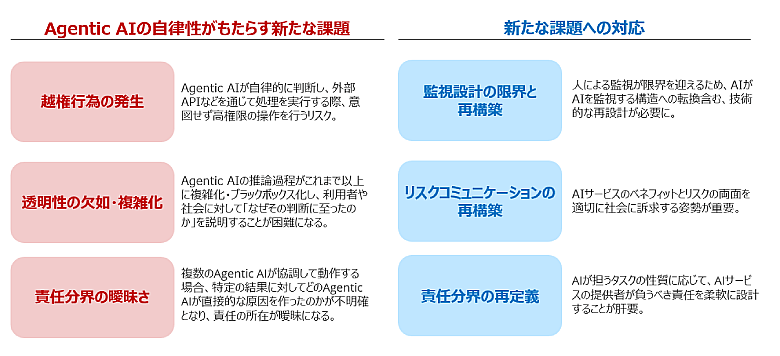

Agentic AIの自律性がもたらす新たな課題と対応

2025年9月2日に開催された「AIアドバイザリーボード総会」では、Agentic AIのリスクと対応策について、社外有識者と社内関係者による活発な議論が交わされ、新たな知見を得ました。ここでは新たな課題への対応についてご紹介します。

図1:Agentic AIの自律性がもたらす新たな課題と対応

監視設計の限界と再構築

Agentic AIの導入にあたって、従来の「監視」という概念が根本的に問い直されています。これまでのAIは、人間が設計したルールに従って動作し、その結果を人間が監視・評価することで安全性を担保してきました。Agentic AIがもたらす課題の一つである「越権行為」に対しても監視は有効な手段の一つと考えられます。しかし、Agentic AIは自らタスクを分解し、外部と連携しながら実行・評価までを行うため、監視の対象や方法そのものが複雑化しています。

AIが自律的に判断し、複数のプロセスを同時並行で進めるようになると、すべての挙動を人間がリアルタイムで把握することは現実的ではありません。たとえば、AIが外部の業務システムと連携して意思決定を行う場合、その判断の根拠や実行内容を人間が逐一確認することは困難です。

このような状況を踏まえ、従来の「人間がAIを監視する」モデルから、「AIがAIを監視する」構造への転換も視野に入れた技術的な再設計が求められています。

リスクコミュニケーションの再構築

AIに対する不安や誤解は、技術そのものよりも、情報の不足や伝え方の問題によって生じることが多くあります。

たとえば、Agentic AIが業務を自律的に遂行することで、業務効率が大幅に向上する可能性があります。しかし、その一方で「AIが勝手に判断するのではないか」「人間の仕事が奪われるのではないか」といった懸念も生まれます。こうした懸念に対して、単に「安全です」と説明するだけでは不十分であり、「どのような仕組みで安全性を担保しているのか」「人間の役割はどう変わるのか」といった具体的な情報を丁寧に伝える必要があります。

社内外のステークホルダーとの対話を通じて、期待値の調整や懸念の共有を行うことも、リスクコミュニケーションの重要な要素です。AIの導入が単なる技術革新ではなく、社会との協働によって進められるべきものであるという認識が、今後ますます重要になっていくでしょう。

責任分界の再定義

Agentic AIが自律的に行動するようになることで、これまで人間の行為を前提に設計されてきた法制度や責任の枠組みが、そのままでは適用しづらくなっています。

まず、Agentic AIの挙動を以下の2つのケースに分類することが考えられます:

- 1.利用者自身でもできることをAIに任せるケース

例:航空券の予約、会議のスケジュール調整など。

この場合、AIは利用者の代理として行動しているに過ぎず、結果を利用者自身が確認・監視できるため、AIに求められる責任は比較的軽くするべきだと考えられます。 - 2.利用者ができないことを専門性を持つAIに任せるケース

例:契約交渉をAIに任せる、医療診断をAIに依頼するなど。

この場合、AIは専門家としての役割を担っており、利用者自身では結果を監視することができません。そのため、AIにはより高度な義務、すなわち専門的な水準で業務を遂行する責任を課す必要があると考えられます。

このように、AIが担うタスクの性質に応じて、どのような責任を課すべきかを整理することが、今後の制度設計において不可欠です。単に「AIも人間と同じ基準でよい」とするのではなく、社会がその基準を受け入れられるかどうかも重要な視点です。たとえば、自動運転車が人間と同じ程度の事故率であっても、その導入が認められにくい現状があります。これは、社会がAIに対して人間と同じ基準を適用することに抵抗を感じる例であり、技術的な妥当性だけではなく、社会的な受容性も考慮した責任設計が求められていることを示しています。

未来を見据えたテクノロジーガバナンスの挑戦

Agentic AIに関する課題と対応策の議論を通じて明らかになったのは、AIガバナンスの枠組みは、今後登場するさまざまな先端技術にも適用・拡張されるべきであるということです。AIアドバイザリーボード総会では、Agentic AIに限らず、Smart RoboticsやBrain Machine Interface(BMI)といった将来技術に対しても、リスクマネジメントと社会受容性の観点から先行的な議論を進めています。

たとえば、ロボティクスの分野においては、ユーザーとのコミュニケーション設計やプライバシー保護、責任分担の明確化が重要な論点となります。またBMIに関しては、脳情報の取り扱いや同意取得の難しさ、企業による利用の限界など、倫理的な課題が多く存在します。

NTT DATAでは、こうした論点に関する社外有識者との議論を通じて、NTT DATAは「技術の可能性」と「社会の安心」を両立させるためのガバナンス設計に取り組んでいます。

まとめ:安心安全なテクノロジー活用を目指して

AIの進化は止まりません。そしてあらゆる分野においてAI活用が進むことで、さまざまなテクノロジーが急速に進歩し、私たちの社会や産業のあり方を大きく変えつつあります。Agentic AIをはじめとする先端技術は、業務効率化や新たな価値創出の可能性を広げる一方で、制御・責任・倫理といった複雑な課題も浮き彫りにしています。

だからこそ、NTT DATAは責任ある技術の社会実装に向けて、AIガバナンスのみならずテクノロジーガバナンスの高度化に挑み続けます。今後も安心安全なテクノロジーの社会実装に向けて、AIアドバイザリーボード総会における議論も含め、さまざまな形で社内外の知見を結集します。そして、実装と統制のバランスを追求することで、社会に信頼される技術活用を推進していきます。

AIガバナンスについてはこちら:

https://www.nttdata.com/jp/ja/services/data-and-intelligence/governance

AIエージェント(AI Agent)についてはこちら:

https://www.nttdata.com/jp/ja/services/generative-ai/ai-agent

あわせて読みたい: